ここのところ、仕事で AI を研究(といっても応用研究だけども)しているので、OpenAI GPT-4 だの、Anthropic Claude 3 だの、大規模言語モデルはいくつも触れている。 AI に固有の知識ベースを与えて質問回答させる RAG システム開発にもトライしている。仕事の話はあまり書かないのだけど、イノベーション・デジタルライフのビッグイベントだったのでブログに書いておく。波形研究所は AI も研究しているのだ。

今日、OpenAI の Spring Update があったが、発表された GPT-4o で OpenAI の目指してきたものが見えてきた。まぁ、目指すものといっても、GPT-4o は彼らが昨年 2023年に取り組んできた研究開発の成果だし、競合の動きをみながらネタを小出しにする作戦なので、実際はもっともっともっと先に進んでいるんだろう。

GPT-4o が目指すもの、いや、目指すものの過程で生まれた GPT-4o

本日発表された GPT-4o は Plus / Team 以上のサブスクライバーにはロールアウトされているし、API 経由でも使うことができるようになる。定番の質問「GPT-4o はいつまでの情報で構築されていますか?」という質問に対しては、「私のトレーニングデータは 2023年10月までの情報 に基づいています」と答えている。GPT-4 相当だ。

もちろん、GPT-4 系には Web Browsing も実装されているので(無償会員は知らない)、最近の話題もキャッチアップしようと思えばできる。だが、2023年 10月あたりに「ここらへんまでにしておこうか」となったことが興味深い。OpenAI は学習したコンテンツを管理できる Media Manager を開発しているが、GPT-4 系はリリース当初に急に賢さが低下したりしていたので、GPT-4 系は学習しているコンテンツも精査・管理できているのかもしれないね。

さて、GPT-4 turbo の次のバージョンが「賢さ」を狙わず、「応答スピード」「コスト」に焦点をあててきたのが面白い。応答スピードはなかなかのものだ。RAG や LLM 処理を行うシステムを開発すると、「応答に 30秒ほどかかるんですけど」という問題が頻出し、これが「現実的に使えるシステム」の実現を難しくしている、ひとつの壁になっている。なので、ベクターデータベースで知識ベース検索部を高速化してから渡そうとか、そんなことをやっていたのが年末年始あたりの話だ。この問題が一挙に解決してしまうかもしれない(えー、マジかー)。

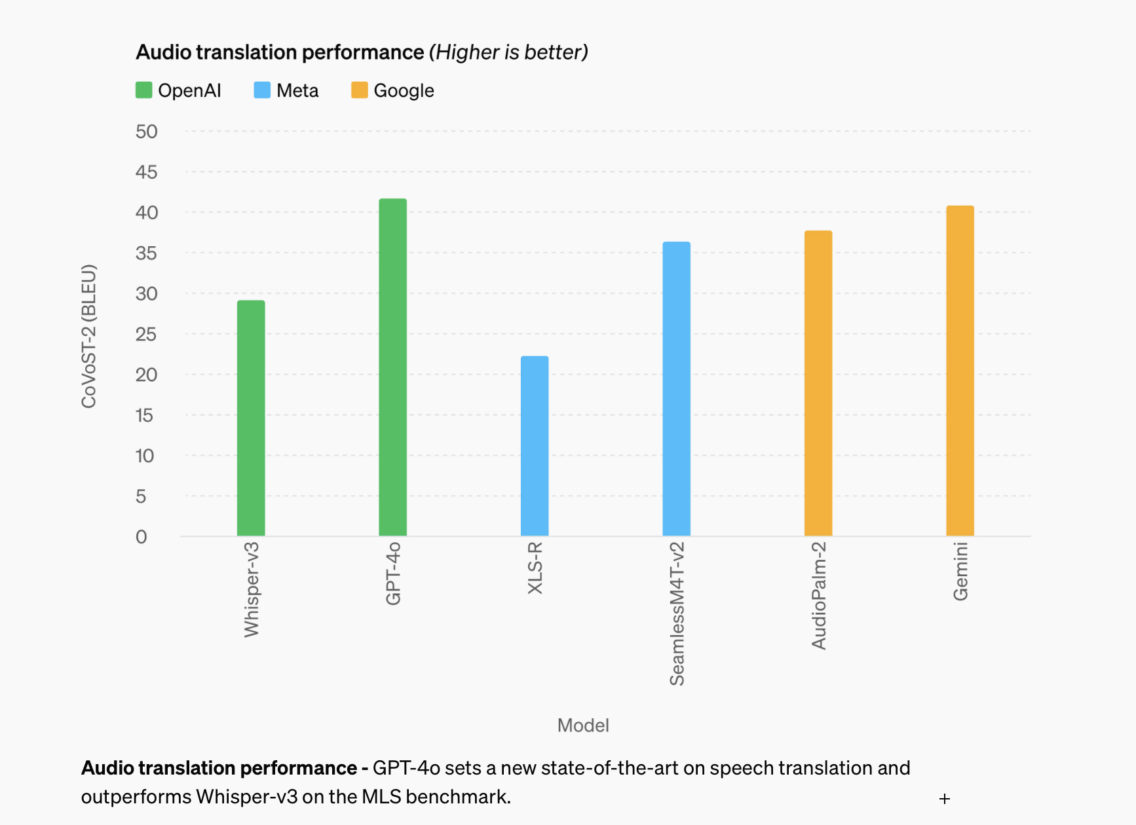

Audio translation performance

プレスリリース・キースピーチをまとめた記事ではカバーしていない話題だが、実は、GPT-4o は単一モデルで「音声・返答処理」を実行している。すべての入力と出力が同じニューラルネットワークによって処理されいている。GPT-4 は既にマルチモーダルと言われているが、音声のディクテーションモデルとマルチモーダルのモデルを掛け合わして実行していた「音声会話」を単独で出来るようになった。そう、GPT-4o は高速に音声会話をするために生まれたのだ。

今回発表されたのは「音声チャットによる応答システム」だ。会話のやりとり(内容ではなく会話のターンの流れ)が人間と話しているのと遜色ないレベルになった。

Siri や Alexa は話してから AI がレスポンスを返すまでにラグがある。通常の人間の会話からは考えられない「間」だ。実は、このタイムラグが会話によるコンピュータ指示を難しくしている。人との会話では問題ないのに、Siri や Alexa への音声指示が苦手な人が多い。それはユーザが無意識のうちに AI とのチャットを「会話」ではなく「音声コマンド」と認識しているからだ。だから、間違わずに指示を出さなきゃ、と緊張してしまう。対人間のやりとりではこういうことは発生しない。

OpenAI アプリの音声会話(今日時点では GPT-4o はロールアウトされていない)では、積極的に「会話」ができる。デモでもスピーカーが AI の話を遮るかのように会話をかぶしている。AI の回答中にユーザが話し出せば、ちゃんと AI は黙って話を聴く。言葉を少々間違えたところで問題ない。

AI コンパニオンを実現するためには賢さよりスピードが必要なのだ。

AI と人間の関係を提示したデモ

今回の OpenAI のデモンストレーションは AI と人間の関係、AI コンパニオンのある生活をはじめて・極めてリアルに想起させた。

なにげない会話をしっかり聞き取り指示を実行するコンパニオン。数学式の解き方を教えてくれたり、通訳が実際にいるかのごとく会話を翻訳したり。会話のトーンを理解し、TPO に合った話し方をする。なんなら歌もうたってくれる。

AI はカメラで状況を認識している。今起こっていること・目に見えるものをしっかり認識し、ユーザの顔色をうかがう。

いよいよメガネ型のインプットデバイスも活躍できるようになるし、Apple Vision Pro にビルトインされればコマンドジェスチャーも出番が少なくなるだろう。

GPT-4o を内蔵した ChatGPT は「会話」においては宇宙戦艦ヤマトのアナライザーや、機動戦士ガンダムのハロを超えている。Apple の Keynote に見慣れている我々からすると、少し拙いデモだったが、今日の出来事は歴史の1ページとして残ることになるだろう。2024年末にはどのくらいのものが出てくるんだろう、と思う。ま、年末より明日の Google がこれを超えてくるかどうか。ま、難しいだろうな。

コメント