WWDC 2024 が開幕した。初日の発表では各 OS の次期バージョン、Vision Pro の世界展開(日本でも販売が開始される!)、そして AI – Apple Intelligence の発表があった。Apple の AI への取り組み・戦略が発表されたのは今回が初めてであり、40分とかなりの時間を割いて説明した。このエントリーでは Apple の AI 戦略について考察する。

Apple と AI のこれまで

GAFAM という言葉はもはや懐かしい響きがあるのだが、世界の IT 最大手が AI に総力をあげて取り組む中で Apple は全く存在感がなかった。ここ10年、ディープ―ニング技術が進化し、物体認識や音声認識の精度が劇的に向上したり、Transformer によって自然言語処理にブレイクスルーが起こったりと技術的イノベーションが起こる中、Apple は何をするつもりなのか、よく分からなかった。

Apple は Siri で話型エージェントを提供しているし、iPhone などパーソナルデータを扱うデバイスをメイン事業としている。ユーザは写真や動画の加工・管理に困っており、メールやメッセージ処理などどう考えても AI がキーテクノロジーになる分野なのに、Apple は AI に触れてこなかったし、明らかに AI という言葉を使うことを避けている感じだった。

しかし、2022年末の OpenAI ChatGPT の登場以降、AI は急速に民主化し、誰でも使えるものとなった。AI は基礎研究領域から応用フェーズに地滑り的に移行し、専門研究者・技術者でなくとも生成AI の可能性・活用法を考えるようになった。

いよいよ、Apple の AI 戦略の不明瞭さが Apple の会社の価値に影響するようになってきたのだ。

Apple の AI 戦略の不明瞭さは、戦略の不在を意味するわけではない。Apple が Apple Silicon の開発において機械学習処理を重視しており、チップセットに Neural Engine コアを搭載、かなり本気で実装してきた。Apple が小規模の AI ベンチャーを買収してきたこともあり、Apple はオン・デバイスで AI を実行したいんだな というのが業界の見立てであった。

プライバシーを重視する Apple が AI をオンデバイスで処理したいと思うのは理解できるが、大規模言語モデルを末端のデバイス単体で実行できるのか??というは疑問が残る。

また、OpenAI GPT-4 や(何度も名前が変わっている)Google Gemini 、Meta Llama などの大規模言語モデルの開発には大規模なデータセンター、膨大な量の GPU、そして電気代がかかるのだが、Apple がそのような大規模投資を行っている、という話は聞こえてこないので、Apple は環境配慮・カーボンニュートラルを重視するために大規模言語モデルを開発できないのでは、と言われていた。

「おいおい、Apple は大丈夫のなか?」となっていたのが Apple と AI のこれまでの話だ。

Apple の AI、それは Apple Intelligence

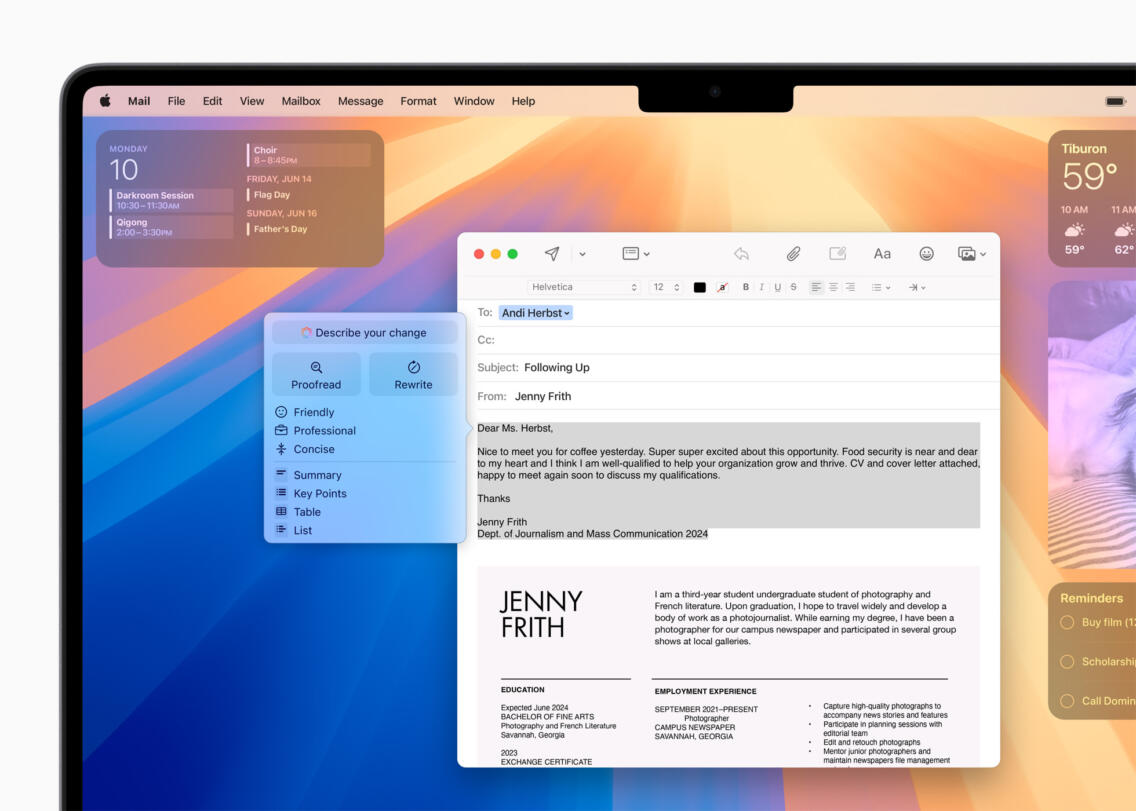

WWDC 2024 で Apple は 自社の AI 戦略 Apple Intelligence を発表した(iPhone、iPad、Macの中心にパワフルな生成モデルを据えるパーソナルインテリジェンスシステム、Apple Intelligenceが登場)。発表内容は他サイトをみてもらうとして、ポイントは以下の通りだ。

- iPhone, iPad, Mac で使える、システムワイドな AI

- ユーザのライフスタイル・データを学習し、パーソナライズされたインテリジェンスを提供

- オンデバイスで実行、大規模処理は専用クラウドで実行

- テキスト生成・画像生成機能を提供、サードパーティにも開放

- 徹底したプライバシー対応

- ChatGPT のような外部 AI も連携、処理・UI を一体化

- 高度な AGI(Artificial General Intelligence, 汎用的人工知能)を目指す

個別に解説する。

iPhone, iPad, Mac で使える、システムワイドな AI

Apple Intelligence は iPhone、 iPad、 Mac で使える、システムワイドな AI だ。具体的には iOS 18、iPadOS 18、macOS Sequoia 以降、ある一定のスペックの Apple Silicon を搭載したデバイスで動作する(説明では Apple Silicon M1 および iPhone 15 Pro が搭載する A17 Pro を対象としているスライドが紹介された)。

Siri の Apple デバイス共通で使える AI エージェントだが、Apple Intelligence は基盤技術の総称だ。Apple Intelligence というアプリがあるのではなく、言語理解、テキストの生成・要約や画像の生成・処理、ユーザデータを学習することで行動・コンテクスト理解など多岐に渡る AI 処理を担当する。

ユーザのライフスタイル・データを学習し、インテリジェンスを提供

ChatGPT や Gemini が主としてインターネットに存在する膨大なオープンデータを学習した知識ベースで構築されているのに対し、Apple Intelligence は iPhone や Mac に保存されているユーザデータを学習しインテリジェンスを提供する。

これは Apple Intelligence がユーザのデータのみを学習して構築される「真なパーソナルな AI 」ということではない。誤解している人もいるようだが、Apple Intelligence もオープンデータを学習して構築された知識ベースだ。Apple Intelligence は ChatGPT や Gemini と異なり、パーソナルなデータも学習した上でインテリジェンスを提供することができる。

少し専門的な話になるが、大規模言語モデル(LLM)に対しユーザデータを与え回答を生成させる手法を RAG( Retrieval-Augmented Generation )と呼ぶ。例えば LLM を使い製品の使用法を回答するチャットボットを作るには、製品マニュアルやサポートの Q&A の情報を検索し、参考になる情報を抽出・組合せてた上で GPT-4 や Claude などの LLM に与え、回答を生成させる。

この方法では、ユーザデータが GPT-4 や Claude といった LLM 提供会社に渡ってしまう。これはフロントアプリケーションを利用しているユーザからすると、データ・機密の漏洩に当たり、彼らがユーザデータを LLM 学習に使ってしまった場合、LLM がユーザデータに近似した内容を回答してしまうかもしれない、というリスクがある。このリスクについては、後述する。

Apple Intelligence は「米国では夏から」「それ以外の国は来年にかけて」提供されるとしている。ChatGPT は Gemini、Claude といった生成 AI はリリース当初から多言語対応しているのだが、ここがは段階的になっているのが面白い。Apple Intelligence はデータ処理を最終的にアプリの実行処理に橋渡しする。これらの処理を行うためにデータを Apple が定義したインテント分類を行っているようだ。

大規模言語モデルはおおざっぱにいって単純に言語の並びを推定する計算モデルだが、「いい感じに用語が並ぶ=返答がマトモ!」なだけでは、アプリの挙動を揃えられないのであろう。これは Apple に好意的な考察であり、実際は「あー、回答品質が使いものにならん!」なんて品質の話なのかもしれない。

オンデバイスで実行、大規模処理は専用クラウドで実行

WWDC キーノートの説明では、Apple Intelligence は高性能な大規模言語モデルと拡散モデルで構成され、デバイス上にユーザデータを学習したセマンティックインデックスが生成・配置し、このインデックスをもとに必要な個人データを集約している、と説明している。より大きなモデル処理や演算能力を必要とした際には、Private Cloud Compute と呼ばれる Apple Silicon で構成された専用クラウドサービスで処理を行う。

Private Cloud Compute はタスク実行に必要なデータのみを暗号化した上で受信・処理し、ユーザデータを保存しない(タスク実行後、破棄される)。また、Apple もこのデータにはアクセスしない。「保存しない」と説明しているが、すぐそのあとに「調査のために公に記録される場合を除き」と説明しているので、ユーザがデータ保存をコントロールできている訳ではない。

テキスト生成・画像生成機能を提供、サードパーティにも開放

Apple Intelligence は ChatGPT や Gemini で一般的な生成AIタスクを実行できるようだ。問題は実行できることではなく、実行結果の品質なのだが、この部分が取り上げて優秀だ、という話は出てこなかった。

「自分や家族・友人の顔写真をもとに画像を生成する」といったプライベートデータを使える、というのは面白いのかもしれない。

徹底したプライバシー対応

Apple Intelligence が徹底したプライバシー対応をもとに設計されているのは前述の通りだ。オンデバイス処理を基本とし、高度なモデル演算は Private Cloud Compute でクラウド処理、情報が蓄積・再利用されることもない。セマンティックインデックスがオンデバイスだとすると、iPhone にあるインデックスは Mac には転送されないはずであり、Apple ID で紐づけるとは思うのだが、具体的にどのように実装しているのか、情報が待たれる。

Apple は Security Research ブログ Private Cloud Compute: A new frontier for AI privacy in the cloud で PPC の設計思想について、もう少し詳しい説明を公開している。

- 個人データにういてはステートレスデータ処理を行う

- プライバシー保証を考慮したコンポーネント設計を行う

- 特権ランタイムアクセスを設定しない

- 任意のデータをターゲティングできない設計

- 高度専門家による透明性設計と検証可能性を確保

各データ処理の前後関係を保持しないステートレスな設計なので、前後のセッション情報から攻撃するデータをターゲティングするようなことができない。ユーザデータを保存せず、断片化されたリクエストをただ処理・返答を行うことに特化したクラウドシステムでプライバシーを確保しようとしているようだ。データセンターのコンポーネント選定の段階からプライバシー規定を遵守している特殊なクラウドシステムで、「実際は GPC / AWS / Azure といったパブリッククラウドでしたー」なんてセンターではないようだ。

ChatGPT のような外部 AI も連携、処理・UI を一体化

これは春に Apple が OpenAI や Google と AI モデルの提供について交渉を行った、というニュースがあった時点で織り込まれているような話だ。OpenAI の GPT-4o をシステムに統合した形で利用することができる。Gemini についても同様の提携があるのだろう。

このニュースが流れた時、プライバシーを重視する Apple がコアの AI モデルを他社に頼るはずがないので、「 Apple の AI/LLM はオープンワールドの知識ベースをサポートしない(GPT-4 や Gemini のような「ナレッジ」がない)」もしくは「具体的に生成処理については性能が出ていない」、という2つのことが予想できた。

Apple が膨大なオープンデータを学習した GPT-4 や Gemini の規模の LLM を作っていない、と予想されたので、前半の理由はそのまま当てはまったといえる。ここは、Apple が検索エンジンを作らない理由と同様だ。

オープンデータの学習は簡単ではない。クロール&学習の作業量だけでなく、ドキュメントの選定と評価分析が必要だからだ。検索エンジンすら持っていない Apple がオープンデータを評価して、効率的にクロール・学習するノウハウがあるとは考えにくい。

「正直、それで大丈夫なのか」と思うが、ここが Apple の限界点なのであろう。

高度な AGI(Artificial General Intelligence, 汎用的人工知能)を目指す Apple

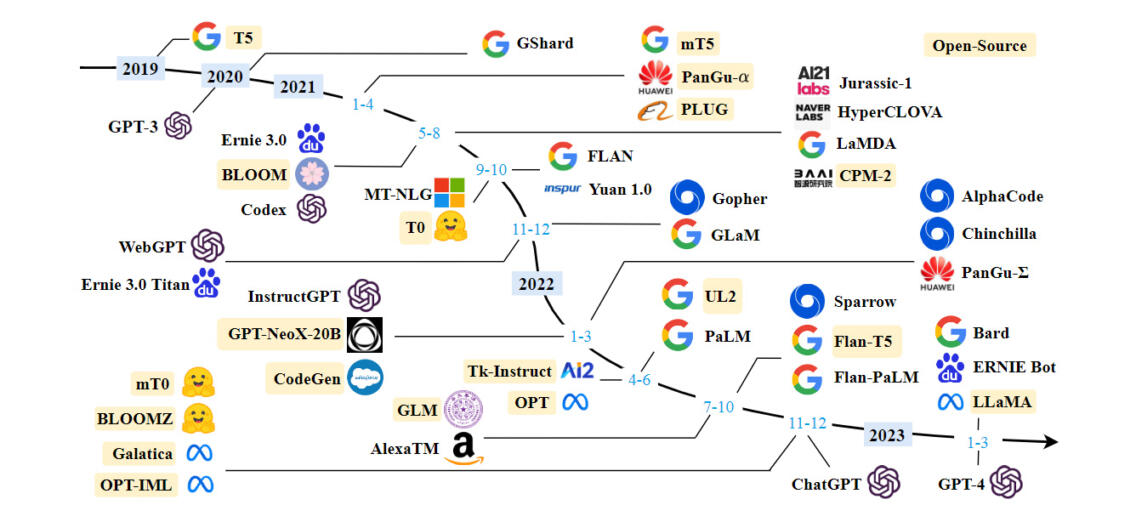

A Survey of Large Language Models arXiv:2303.18223

必然な流れ・文脈の中で Apple Intelligence は登場した。これが世の中の人の想像を越えたのか、といえば拍子抜けしている人も多いと思う。Apple Intelligence は、構築するのは大変な偉業なのだが、AI としてイノベーティブか、といえばそうでもない。

Apple は AI については一貫して応用領域に特化してきたんだと思う。Google の研究者は Transformer などニューラルネットワーク技術に大きく貢献してきた。Meta は Llama 2 を公開し、多くのローカル LLM は Llama をベースとしている。Amazon も独自の LLM やエンベディングモデルを多く提供している。自分の仕事においても、Google、Amazon、Microsoft、Meta、OpenAI、Anthropic といった企業の AI 研究成果に本当にお世話になっているのだが、Apple に感謝したことはない。

個人的に心配しているのは、Apple Intelligence の性能だ。

「AIにおけるプライバシーの新しい基準を打ち立てるApple Intelligenceは、個人的な背景を理解し、各ユーザーに有用で関連性のあるインテリジェンスを提供します」

Apple が定義している後半の「有用で関連性のあるインテリジェンス」が本当に実現するのか。この技術の性能については今回、全く語られなかった。

Apple はハードウェアを作るのは得意でも、インターネットアプリケーション構築が得意なイメージがない。iCloud は品質がアレだったし、マップサービスも悪夢だった。技術力において Apple は先行逃げ切り型であり、他社が専業で必死に取り組んで実現したサービスを後から追撃・凌駕したことがない。多くの人は Apple Intelligence の品質を心配している。

Apple は高度な AGI(Artificial General Intelligence, 汎用的人工知能)を目指している。未来の社会で描かれる AI コンパニオンを実現しようとしている。それは凄いことだし、Apple のポジションはその目的の達成に近いところにあるとも思う。

でも、AI に関してユーザが気になるのは「回答品質」であり、「使えるか」だ。OpenAI ChatGPT は既に宇宙戦艦ヤマトのアナライザーや機動戦士ガンダムのハロを実現してしまっている。Apple の作る AI は本当に AI コンパニオンになり得るのか。

「金曜の 19時にボブとの夕食の予定を入れて!」

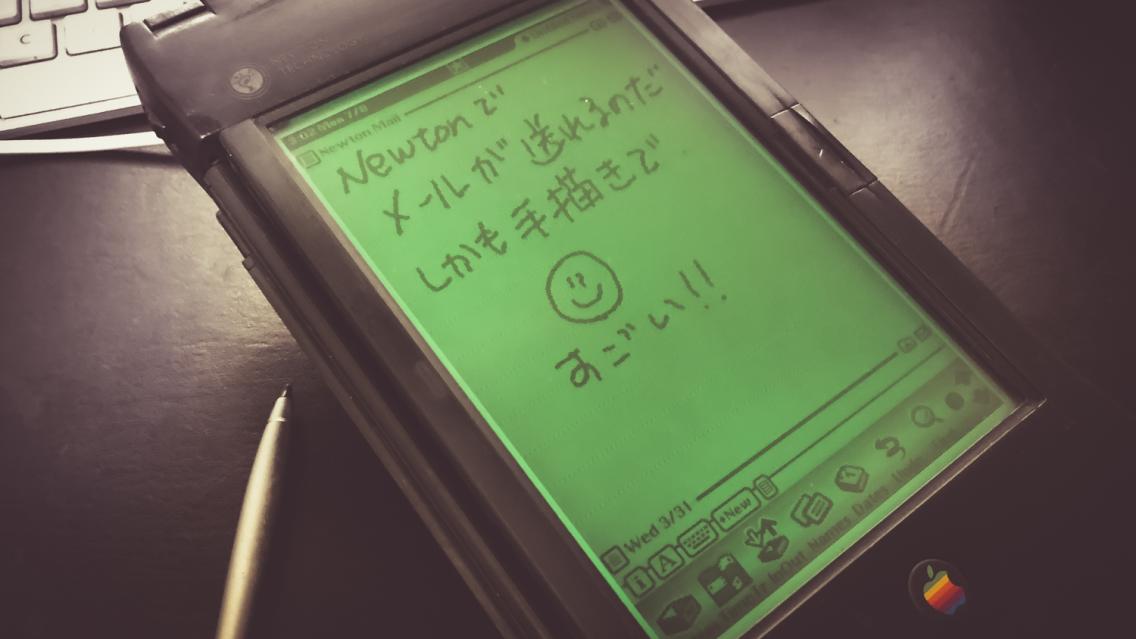

こんなことは 80年代に Apple が Newton OS で実現する、と言っていた機能だ(笑)。Newton の Assist は AI コンパニオンであり、そのコンセプトは時代を先取りしていたが、いかんせん品質が付いてこなかった。

Apple Intelligence は満を持して登場したのか、追い込まれて発表しちゃった案件なのか。

ちょっぴり不安を感じつつも、大いに期待している。

コメント

私のMessagePad 2100 は、2025.01.04 以降、カレンダー機能がおかしくなりました。

2010年問題のpatchはあててあります。何か情報をいただけたら幸いです。